深度學習環境搭建與遠程數據傳輸解決方案詳解

在深度學習領域,人們常用遠程云服務器進行研究,但這其中存在的難題卻讓許多人感到頭疼。比如,環境的搭建、保存以及數據的遠程傳輸,這些問題處理起來都挺復雜。

深度學習環境搭建之鏡像選擇

阿里云等云服務平臺上購買服務器并創建實例時,用戶可以選擇預配置的鏡像。這樣做有幾個優點,比如能減少搭建環境以及安裝顯卡驅動所需的時間。記得2018年我進行一個圖像識別項目時,就是選擇了現成的鏡像,前期準備工作非常迅速。不過,這種方法也有其局限性。比如,若對深度學習框架的版本有特定需求,可能會遇到一些麻煩。就有一位同事因此在使用過程中遇到了軟件兼容性的問題。

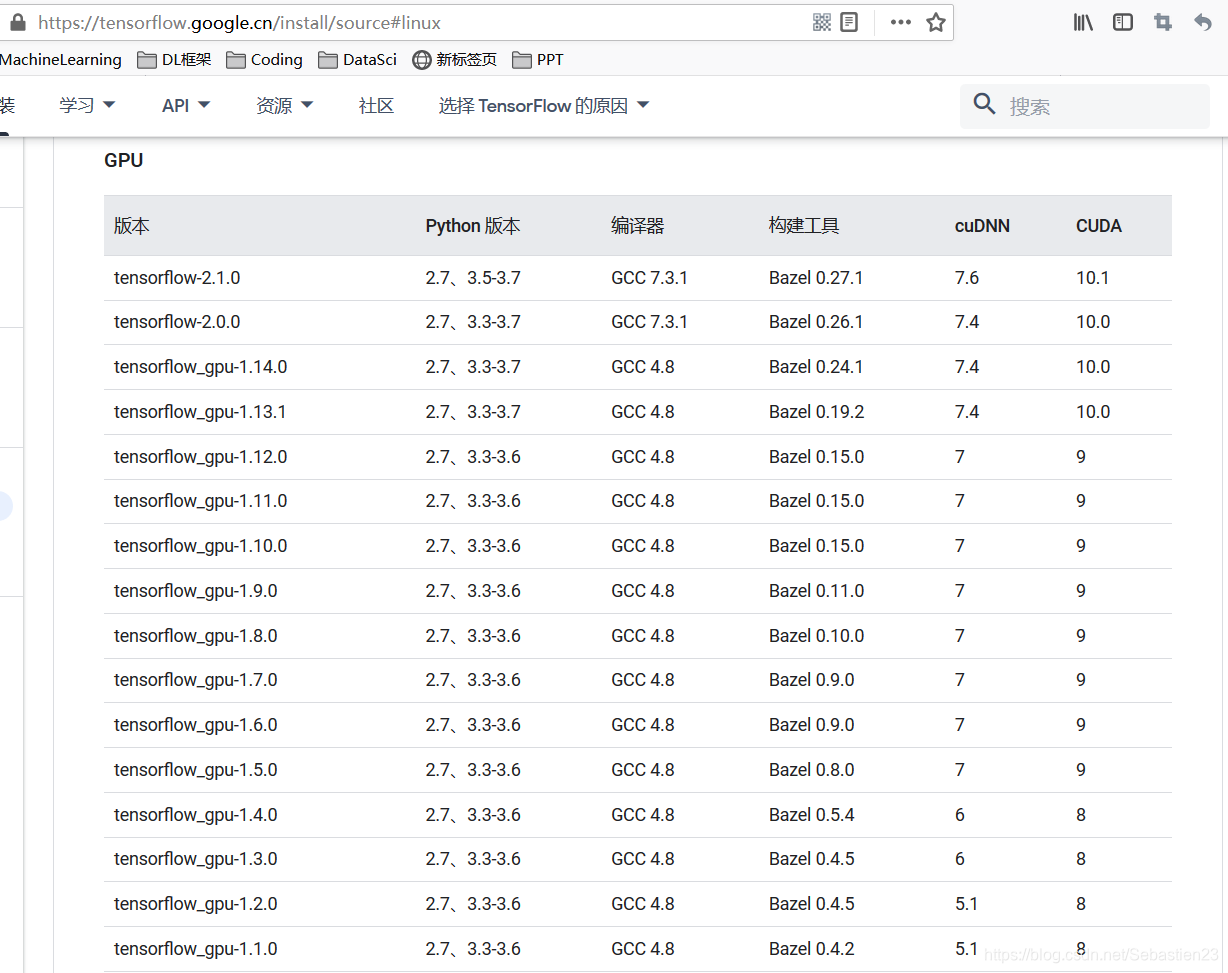

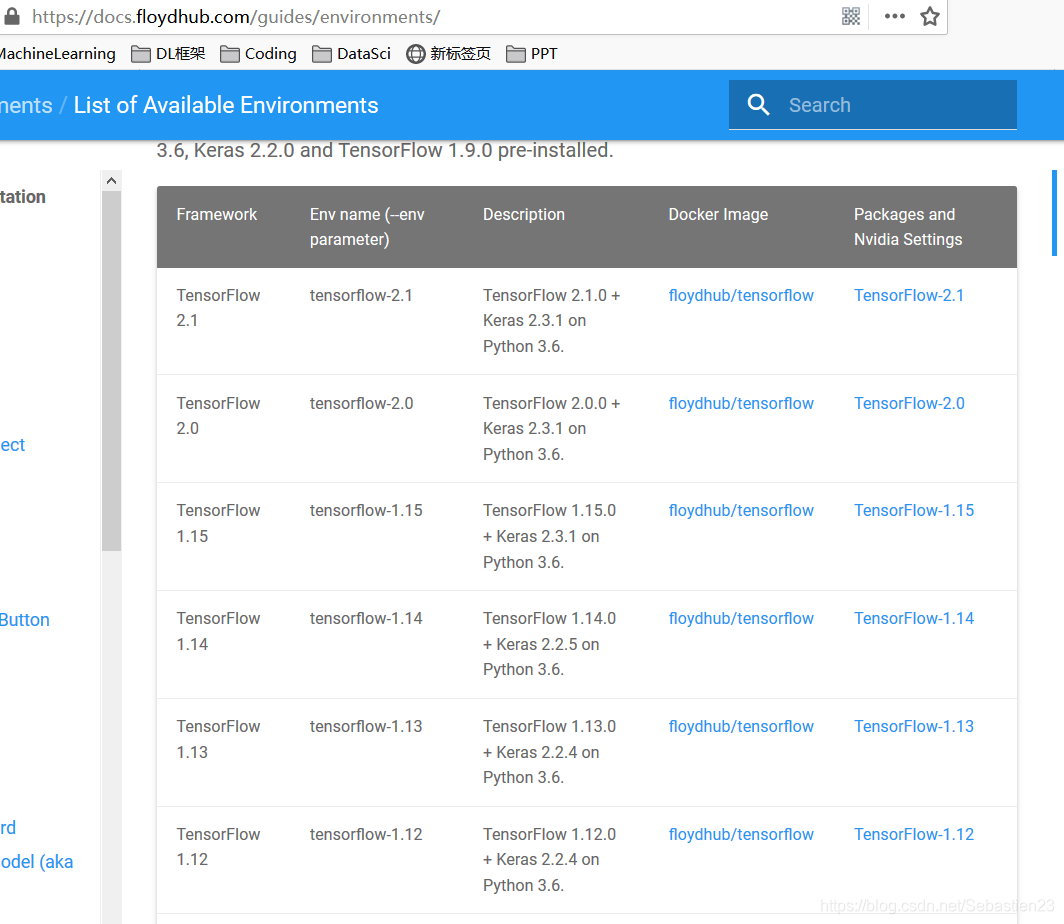

自己動手搭建環境,別忘了安裝必要的框架,比如TensorFlow或PyTorch,還有像numpy這樣的數據處理庫。同時,顯卡驅動也不能忽視,還得留意它們之間的版本匹配。我有個朋友就為此頭疼了很久,直到搞清楚CUDA和深度學習框架版本兼容的問題。

深度學習環境搭建之框架與庫

安裝深度學習相關框架和庫需謹慎。不僅包括之前提到的核心框架,可能還需額外安裝如Keras等。這些框架和庫間有版本匹配的要求。例如,GPU相關的GCC、CUDA、cuDNN與Keras等,它們的版本必須匹配。2019年我參與情感分析項目時,因未妥善處理版本問題,導致模型訓練出錯。各版本間就像拼圖,一旦某一塊出錯,整個拼圖就無法完成。選擇版本時,需綜合考慮研究目標和個人數據情況。

安裝過程中常常會遇到一些預料之外的問題,例如依賴項不匹配等情況。在這種情況下,我們通常需要上網搜索相關信息或向技術論壇求助。以我之前安裝matplotlib庫的經歷為例,就遇到了依賴項的問題,花費了不少時間才最終解決。

已搭建環境的保存之自定義鏡像

自行搭建的環境云服務器,通過制作個性化鏡像是一種不錯的選擇。例如,在進行科研工作時,保存階段性環境顯得尤為重要。這樣做可以在實例釋放后,快速恢復原有環境。有團隊曾因忽視這一點,每次重建環境都耗費了大量時間。制作個性化鏡像需遵循既定的操作步驟。

采用按量計費并做好數據備份可以有效減少開支。實驗結束后,記得把數據保存在安全的地方,比如個人電腦或遠程的安全存儲庫。這樣,你就可以安心地關閉實例,從而節省費用。2020年,有一支新成立的研究團隊就因為未進行數據備份,導致數據丟失,不得不從頭開始。

創建實例時需挑選恰當的付費模式,例如按需付費。一家初創企業對此尤為重視成本管理,長期堅持使用按需付費,通過巧妙安排工作時間段,節省了大量費用。每次進行實驗前,他們都會從自定義鏡像啟動實例,實驗結束后,則依照規定流程進行后續處理。

需結合個人實際情況合理安排實例的釋放與創建時間。對于依賴環境較少的簡易實驗,可適當縮短實例釋放的周期。至于那些持續時間較長的項目,在釋放實例之前,務必仔細核對數據備份是否完整等相關事宜。

遠程數據的傳輸之后臺運行

使用深度學習模型時,若長時間無人操作,網絡連接可能會中斷。因此,讓模型在后臺持續運行是很有必要的。記得有一次,我在訓練模型時,早上開始連接并啟動訓練,可中午吃飯回來發現連接已斷。后來我才明白,應該讓模型后臺運行。這樣做可以防止軟件中斷,減少因重新開始訓練帶來的麻煩。

運行于后臺能夠有效提升效率。在日常工作之余,人們常交流模型進展,后臺運行確保了進程不會因意外而停滯。對于那些有特定顯示要求或需實時監控的模型,則需考慮更細致的配置。

遠程數據的傳輸之傳輸工具

若需進行數據遠程傳輸,使用putty或scp、pscp等軟件非常實用。只需在本地系統上安裝pscp.exe并將其置于指定文件夾。我們的數據分析師常借助這些軟件在本地與云端服務器間進行數據交換。不同操作系統在安裝時可能存在差異,需注意相關要求和細節。

傳輸數據時,安全性同樣不容忽視。以涉及隱私的數據集為例,必須保證傳輸通道的加密措施。當傳輸大量數據時,速度可能會降低,因此需要對網絡帶寬做出合理預估。

source activate tensorflow_env # 激活深度學習環境

nohup jupyter notebook & # 后臺運行并將數據保存到nohup.out文件中

nohup jupyter notebook --allow-root & # 如果是root用戶

ps -aux | grep jupyter # 查看jupyter notebook進程號,假設是1842

kill -9 1842 # 停止后臺運行

在使用遠程云服務器進行深度學習模型訓練時,大家是否遇到了一些獨特的問題?歡迎大家在評論區留言、點贊以及轉發這篇文章。

作者:小藍

鏈接:http://m.huanchou.cn/content/6043.html

本站部分內容和圖片來源網絡,不代表本站觀點,如有侵權,可聯系我方刪除。