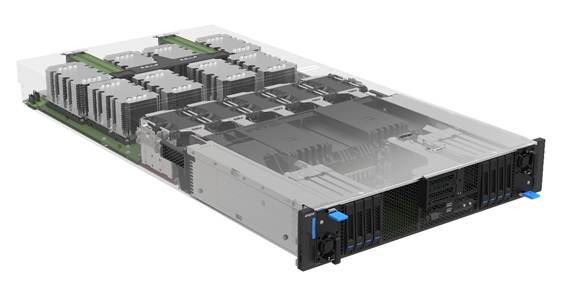

浪潮發布全球首款2U8 NVLink? GPU AI服務器NF5288M5,解析AI計算設備的設計與價值

如今,隨著人工智能的迅猛發展,對計算能力的渴求急劇上升。然而,現有的計算平臺卻面臨著不少挑戰。浪潮與NVIDIA攜手推出的這款產品,宛如一把解鎖難題的鑰匙,讓人充滿期待。

AI發展現狀與計算平臺困境

AI訓練進展迅速,對計算能力的需求急劇上升。眾多AI研發企業在開展大規模模型訓練時,往往面臨計算資源不足的問題。市場上的AI計算平臺存在通信效率不高、架構不夠靈活、計算密度較低等問題。特別是對于一些小型AI創業公司來說,由于預算限制,所購計算平臺效率不高,這極大地制約了它們的業務拓展。

新環境對異構服務器提出了多種需求。科研機構與商業公司的AI應用各有特點,需求差異顯著。比如,藥物研發中訓練AI模型所需的數據并行處理方式,與自動駕駛領域所采用的并行處理模式截然不同。

應對多樣的AI訓練場景需求

某些模型在訓練過程中高度依賴GPU的加速功能。特別是在圖像識別等應用中,處理大量圖像數據時,GPU強大的并行計算能力是快速完成任務的必要條件。而對于其他一些任務,比如自然語言處理中的某些程序,就需要CPU和GPU共同協作,通過迭代的方式來提升工作效率。

模型訓練過程中,收斂效果顯著依賴于眾多GPU資源。例如,某些超大規模氣象預測模型,需要由200多塊GPU卡構成的集群進行并行運算,才能確保在限定時間內達到理想的收斂水平。

極致的計算架構效率提升

舍棄非同構的設計,轉向采用同構架構。在這個平臺中,2U的空間足以容納8塊特定的GPU。它無需依賴CPU即可實現直接的點對點通信。以大型互聯網公司的數據中心為例,這種通信模式顯著降低了異構通信的頻率。

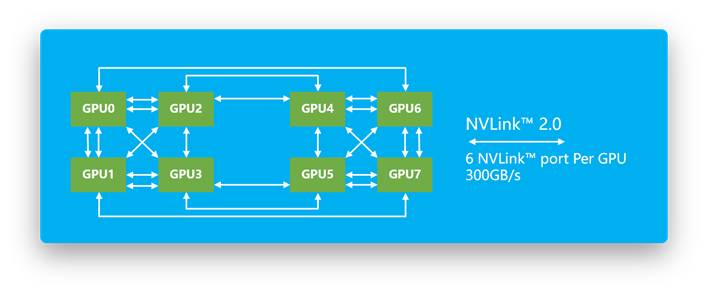

該平臺兼容新型GPU,并且具備較高的互連帶寬。它首次引入了對新型GPU系列的支持,實現了GPU之間300GB/s的高速互連和低延遲。這對于深度學習領域的研究室來說,多GPU并行處理能力顯著增強,從而顯著減少了模型訓練所需的時間。

提升超大規模應用效益

降低數據中心資源消耗。在使用超大規模AI訓練集群或高性能計算集群時,可以有效節約基礎設施資源。例如,大型云計算服務商能夠利用這一點,優化數據中心的空間布局,減少開支。

提高服務器運算效能。借助計算架構的改進等措施,滿足AI應用對強大計算能力的不斷追求。眾多科技企業采納此技術,有效提升了產品研發速度,從而在激烈的市場競爭中占據了有利地位。

靈活的計算拓撲優勢

對CPU的連接配置進行優化。使用PCIe電纜將CPU與GPU相連,能夠方便地調整帶寬和連接數目。對于類似小型AI工作室這樣的機構,可以依據具體項目需求靈活分配PCIe資源,以此減少開支。

增加GPU的數量在垂直方向上。這允許采用不同的CPU管理GPU的方式,并支持最多擴展到16個GPU。例如,隨著中型AI企業業務的擴大,它們可以方便地調整計算資源的配置。

面臨的設計挑戰與解決辦法

供電散熱問題較為復雜。GPU的靈活配置不易實現,同時滿足高功率需求和有限空間內的散熱需求更是挑戰重重。尤其是在空間緊湊的企業機房中,這些問題顯得尤為突出。

浪潮的方案設計。參考了刀片服務器與8路服務器的布局經驗,對組件進行了優化。這確保了GPU的強大性能。在眾多對空間和性能有高要求的企業中,該方案確保了設備穩定且高效地運作。

大家對這種新型的計算平臺在AI領域普及所需的時間有何看法?期待大家踴躍點贊、轉發,并在評論區展開討論。

作者:小藍

鏈接:http://m.huanchou.cn/content/6184.html

本站部分內容和圖片來源網絡,不代表本站觀點,如有侵權,可聯系我方刪除。